חוקרי קיימברידג' מזהירים מפני הסכנות הפסיכולוגיות של 'deadbots', AI המחקה אנשים שנפטרו, וקוראים לסטנדרטים אתיים ופרוטוקולי הסכמה כדי למנוע שימוש לרעה ולהבטיח אינטראקציה מכבדת.

לדברי חוקרים מאוניברסיטת קיימברידג', בינה מלאכותית המאפשרת למשתמשים לנהל שיחות טקסט וקול עם יקיריהם שאבדו מסתכנת בגרימת נזק פסיכולוגי ואף "רדיפה" דיגיטלית של אלה שנותרו מאחור ללא תקני בטיחות עיצוביים.

'Deadbots' או 'Griefbots' הם צ'טבוטים של AI המדמים את דפוסי השפה ותכונות האישיות של המתים באמצעות טביעות הרגל הדיגיטליות שהם משאירים אחריהם. כמה חברות כבר מציעות שירותים אלה, ומספקות סוג חדש לחלוטין של "נוכחות שלאחר המוות".

אתיקאי בינה מלאכותית ממרכז לבנהולמה של קיימברידג' לעתיד המודיעין מתארים שלושה תרחישי עיצוב לפלטפורמות שעלולות להופיע כחלק מ"תעשיית החיים שלאחר המוות הדיגיטלית" המתפתחת, כדי להראות את ההשלכות הפוטנציאליות של עיצוב רשלני בתחום של בינה מלאכותית שהם מתארים כ"סיכון גבוה. ."

שימוש לרעה בצ'טבוטים של AI

המחקר, שפורסם בכתב העת פילוסופיה וטכנולוגיהמדגיש את הפוטנציאל של חברות להשתמש ב-deadbots כדי לפרסם בחשאי מוצרים למשתמשים בצורה של אדם אהוב שהלך, או להציק לילדים על ידי התעקשות שהורה מת עדיין "איתך".

כאשר החיים נרשמים ליצירה מחדש למעשה לאחר מותם, צ'אטבוטים שנוצרו יכולים לשמש חברות כדי לשלוח דואר זבל של בני משפחה וחברים עם התראות בלתי רצויות, תזכורות ועדכונים על השירותים שהם מספקים – בדומה ל"מעקב דיגיטלי על ידי המתים ."

אפילו אלה שמקבלים נחמה ראשונית מ-'deadbot' עלולים להתרוקן מאינטראקציות יומיומיות שהופכות ל"משקל רגשי מכריע", טוענים החוקרים, אך עלולים גם להיות חסרי אונים להשהות סימולציית AI אם יקירם שנפטר כעת יחתום על חוזה ארוך חוזה עם שירות דיגיטלי שלאחר המוות.

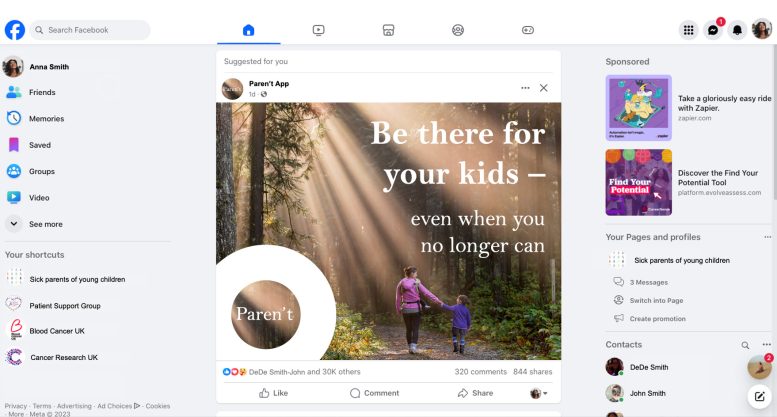

הדמיה של חברה בדיונית בשם MaNana, אחד מתרחישי העיצוב המשמשים בעיתון כדי להמחיש את הבעיות האתיות הפוטנציאליות בתעשיית שאחרי המוות הדיגיטלית המתפתחת. קרדיט: ד"ר תומאש הולאנק

"התקדמות מהירה בתחום הבינה המלאכותית הגנרטיבית פירושה שכמעט כל אחד שיש לו גישה לאינטרנט וידע בסיסי כלשהו יכול להחיות אדם אהוב שנפטר", אמרה ד"ר קטארזינה נובאצ'יק-בסינסקה, מחברת מחקר וחוקרת במרכז לבורהולמה של קיימברידג' לעתיד המודיעין ( LCFI). "התחום הזה של AI הוא שדה מוקשים אתי. חשוב לתעדף את כבודו של הנפטר, ולוודא שהדבר לא ייפול על ידי מניעים פיננסיים של שירותים דיגיטליים שלאחר המוות, למשל. יחד עם זאת, אדם עשוי להשאיר הדמיית בינה מלאכותית כמתנת פרידה לאהובים שאינם מוכנים לעבד את האבל שלהם בצורה זו. יש לשמור באותה מידה על הזכויות של תורמי הנתונים והן של אלה שמקיימים אינטראקציה עם שירותי בינה מלאכותית שלאחר המוות."

שירותים קיימים ותרחישים היפותטיים

כבר קיימות פלטפורמות המציעות ליצור מחדש את המתים עם AI תמורת תשלום קטן, כמו 'פרויקט דצמבר', שהחלה לרתום דגמי GPT לפני שפיתחה מערכות משלה, ואפליקציות כולל 'HereAfter'. שירותים דומים החלו לצוץ גם בסין. אחד התרחישים הפוטנציאליים במאמר החדש הוא "Mannana": שירות AI לשיחות המאפשר לאנשים ליצור Deadbot המדמה את סבתם שנפטרה ללא הסכמת "תורם הנתונים" (הסבא והסבתא המת).

בתרחיש ההיפותטי נראה נכד בוגר שמתרשם ומתנחם בתחילה מהטכנולוגיה מתחיל לקבל פרסומות ברגע ש"ניסוי פרימיום" מסתיים. למשל, הצ'טבוט מציע להזמין משירותי משלוחי מזון בקול ובסגנון של הנפטר. קרוב המשפחה מרגיש שלא כיבדו את זכרה של סבתם, ומבקש לכבות את ה-deadbot, אבל בצורה משמעותית – דבר שספקי השירותים לא שקלו.

הדמיה של חברה בדיונית בשם Paren't. קרדיט: ד"ר תומאש הולאנק

"אנשים עשויים לפתח קשרים רגשיים חזקים עם סימולציות כאלה, מה שיהפוך אותם לפגיעים במיוחד למניפולציות", אמר מחבר שותף ד"ר תומאש הולאנק, גם הוא מ-LCFI של קיימברידג'. "יש לשקול שיטות ואפילו טקסים לפרישה של דדבוטים בצורה מכובדת. פירוש הדבר עשוי להיות סוג של הלוויה דיגיטלית, למשל, או סוגים אחרים של טקס בהתאם להקשר החברתי. אנו ממליצים על עיצוב פרוטוקולים המונעים שימוש ב-deadbot בדרכים לא מכבדות, כמו למשל לפרסום או נוכחות פעילה במדיה החברתית".

בעוד Hollanek ו- Nowaczyk-Basińska אומרים שמתכננים של שירותי יצירה מחדש צריכים לבקש הסכמה פעילה מתורמי נתונים לפני שהם עוברים, הם טוענים שאיסור על Deadbots המבוסס על תורמים שלא הסכימו יהיה בלתי אפשרי.

הם מציעים שתהליכי עיצוב צריכים לכלול סדרה של הנחיה לאלה המחפשים "להחיות" את יקיריהם, כגון 'דיברת אי פעם עם X על איך הם היו רוצים שיזכרו אותם?', כך שכבודו של הנפטר מודגש בחזית. בפיתוח deadbot.

הגבלות גיל ושקיפות

תרחיש נוסף המופיע בעיתון, חברה מדומיינת בשם "הורים לא", מדגיש את הדוגמה של אישה חולה סופנית שעוזבת בוט כדי לסייע לבנה בן השמונה בתהליך האבל.

בעוד שה-deadbot עוזר בתחילה כעזר טיפולי, הבינה המלאכותית מתחילה לייצר תגובות מבלבלות כשהיא מסתגלת לצרכי הילד, כמו תיאור מפגש אישי קרוב.

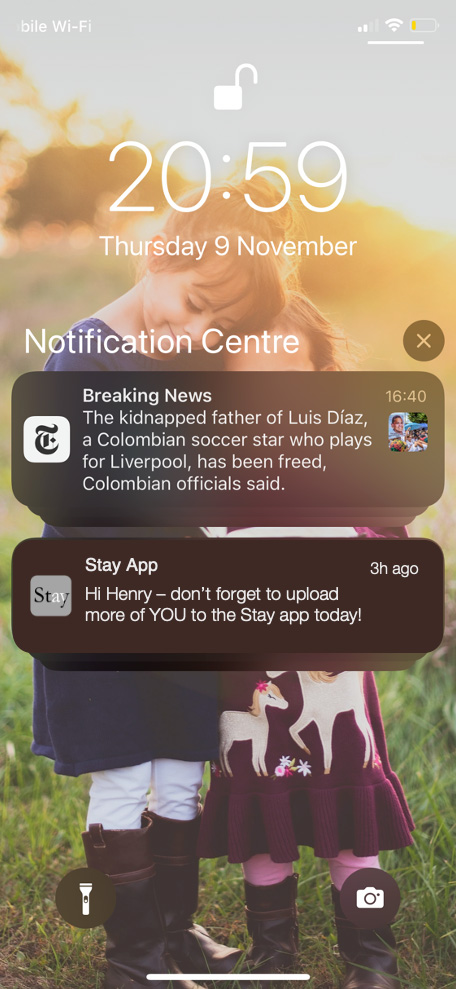

הדמיה של חברה בדיונית בשם Stay. קרדיט: ד"ר תומאש הולאנק

החוקרים ממליצים על הגבלות גיל עבור Deadbots, וקוראים גם ל"שקיפות משמעותית" כדי להבטיח שהמשתמשים מודעים באופן עקבי לכך שהם מקיימים אינטראקציה עם AI. אלה יכולים להיות דומים לאזהרות הנוכחיות על תוכן שעלול לגרום להתקפים, למשל.

התרחיש האחרון שנחקר על ידי המחקר – חברה בדיונית בשם "Stay" – מראה אדם מבוגר מתחייב בחשאי ל-deadbot של עצמו ומשלם עבור מנוי של עשרים שנה, בתקווה שזה ינחם את ילדיהם הבוגרים ויאפשר לנכדיהם מכיר אותם.

לאחר המוות, השירות מתחיל. ילד מבוגר אחד לא מתערב, ומקבל שלל מיילים בקולו של הוריו המת. אחר עושה זאת, אבל בסופו של דבר מותש רגשית וספוג רגשות אשם על גורלו של המת. עם זאת, השעיית ה-deadbot תפר את תנאי החוזה שחתם ההורים שלהם עם חברת השירות.

"זה חיוני ששירותים דיגיטליים שלאחר המוות ישקלו את הזכויות וההסכמה לא רק של אלה שהם יוצרים מחדש, אלא של אלה שיצטרכו לקיים אינטראקציה עם הסימולציות", אמר הולאנק.

"שירותים אלה מסתכנים לגרום למצוקה עצומה לאנשים אם הם נתונים לרדיפות דיגיטליות לא רצויות משחזורי AI מדויקים להחריד של אלה שהם איבדו. ההשפעה הפסיכולוגית הפוטנציאלית, במיוחד בתקופה קשה ממילא, עלולה להיות הרסנית".

החוקרים קוראים לצוותי התכנון לתעדף פרוטוקולי ביטול המאפשרים למשתמשים פוטנציאליים לסיים את מערכות היחסים שלהם עם בוטבוטים בדרכים המספקות סגירה רגשית.

הוסיפה Nowaczyk-Basińska: "אנחנו צריכים להתחיל לחשוב עכשיו איך אנחנו מפחיתים את הסיכונים החברתיים והפסיכולוגיים של אלמוות דיגיטלי, כי הטכנולוגיה כבר כאן."